"국내 고객은 한국어로도 부담 없이 코파일럿 내 GPT-4로 개발할 수 있다. 마이크로소프트팀은 오픈AI와 손잡고 토큰 수 효율화를 이뤘다. 한국어 특성상 영어보다 평균 2배 더 많은 토큰 수가 필요했지만, 이젠 1.1배로 줄었다."

마이크로소프트 스콧 한셀만 개발자 커뮤니티 부사장은 30일 양재 aT센터에서 열린 '마이크로소프트 AI 투어 인 서울'에서 코파일럿 제품 내 탑재된 오픈AI의 GPT-4 토크나이저 효율화를 강조했다.

보통 토큰 수는 생성형 AI로 개발에 필수 요소다. 토큰 수에 따라 지불해야 하는 비용도 상이하다. 토큰 수가 많으면 사용자는 높은 비용을 지불해야 한다. 모델마다 한번에 입력할 수 있는 토큰 수도 정해졌다.

스콧 한셀만 부사장은 "보통 같은 질문을 모델에 입력할 때, 한국어는 영어보다 약 2배 더 많은 토큰 수가 필요하다"고 설명했다. 그는 이에 대한 근거도 제시했다. 마이크로소프트 아시아팀 분석 결과에 따르면, 한국어는 GPT-4에서 영어보다 평균 2.36배 많은 토큰 수가 들었다.

한셀만 부사장은 "토큰 효율화를 위해 마이크로소프트팀과 오픈AI가 손잡고 연구했다"며 "똑같은 질문에 언어마다 토큰 수 차이가 없도록 하기 위함"이라고 설명했다.

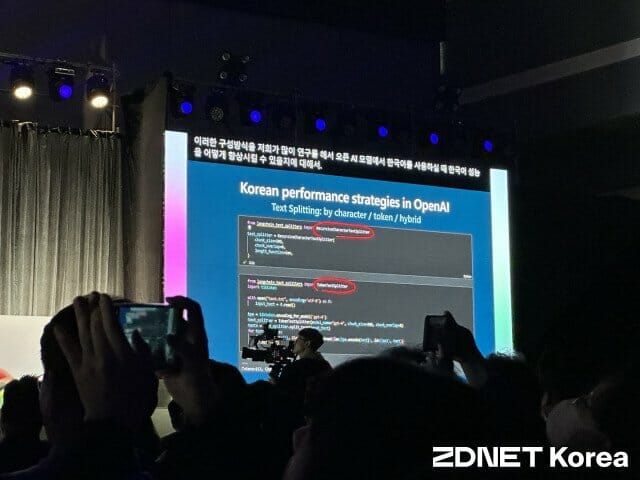

오픈AI 멀티모달 모델 GPT-4에 토큰 수 개선이 이뤄졌다고 했다. 그는 모델이 토큰 수 나누는 방식을 설명했다. 현재 GPT-4의 토크나이저는 BPE 기반으로 작동한다. 바이트 기반으로 토큰을 나눈다. 이는 한국어를 텍스트 처리할 때 자음과 모음의 결합으로 본다거나 형태소 단위로 수치화하지 않는다.

대신 특정 음절의 빈도수나 문장 복잡성에 기반해 토큰 수를 측정한다. 기존보다 토큰 수를 줄이는 방식이다. 시맨틱 커널 방식을 비롯한, 스플리팅 전략도 활용한다.

한셀만 부사장은 "오픈AI 모델은 시맨틱 커널 등으로 토큰 수를 측정하고 있다"며 "이에 따라 한국어는 영어보다 약 1.1배 더 많이 드는 수준"이라고 했다. 기존보다 토큰 효율화를 50% 이상 올린 셈이다. 해당 기능은 지난달 처음 공개한 바 있다.

그는 "현재 애저 오픈AI 서비스 등 다양한 제품에서 한국어 토큰 수 효율화를 경험할 수 있을 것"이라며 "한국어 처리 AI 미래에 큰 도움 될 것"이라고 했다.

"한국어 AI 모델에 집착할 필요 없다"

업계에서는 애저 오픈AI 서비스 등 마이크로소프트 솔루션 내에서 한국어 토큰 효율화를 경험할 수 있을 것으로 내다봤다.

그동안 국내 AI 기업들은 GPT-4 토큰 비용을 언급한 바 있다. 국내 사용자가 한국어 기반 작업에 GPT-4를 이용하면 비싼 비용을 지불해야 한다고 지적했다.

관련기사

- 마이크로소프트 "사무용 앱서 일하는 코파일럿, 한국말 한다"2024.04.30

- "더 똑똑하고 저렴"…마이크로소프트, 소형 AI모델 '파이3 미니' 출시2024.04.24

- 마이크로소프트, 국내외 기업 AI 전환 사례 공개2024.04.22

- 마이크로소프트, 다이나믹스365 가격 10% 이상 인상 예고2024.04.16

이번 마이크로소프트와 오픈AI의 토큰 효율화 후 이같은 주장은 잠잠해질 것이라는 의견이 나오고 있다. 이날 부스를 지키던 마이크로소프트 관계자도 GPT-4의 한국어 토큰 효율성에 대해 재차 강조했다.

그는 "국내 사용자가 네이버 '하이퍼클로바X' 등 한국어 기반 모델을 굳이 활용하지 않아도 되는 시대"라며 "비슷한 비용으로 GPT-4를 통한 개발 작업을 한국어로 할 수 있을 것"이라고 강조했다.